什么是模型上下文协议 (MCP)?

简单说,模型上下文协议 (MCP) 是 Anthropic 搞出来的一个开放标准,让 AI 应用能更方便地跟各种数据源“勾搭”上。

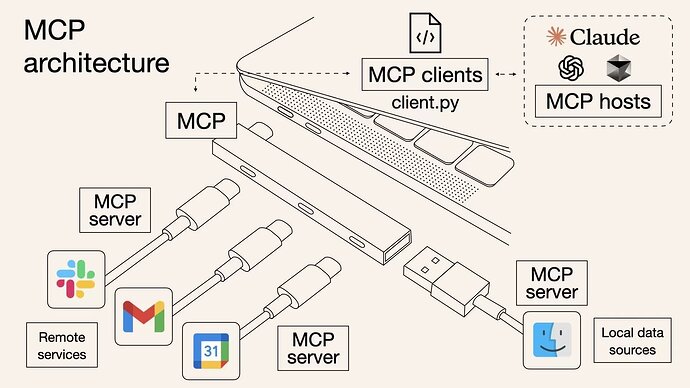

你可以把它想象成 AI 界的 USB-C 接口:USB-C 让你各种设备都能连上不同的配件,MCP 让 AI 模型能连上数据库、API、文件系统啥的。

MCP 咋工作的?

MCP 玩的是 客户端-服务器 这一套:

- AI 助手(比如 Claude)想知道点啥或者做点啥,它就发个请求。

- MCP 服务器就跑去数据库、文档夹或者在线服务那儿找信息,然后把找到的东西发回去。

- AI 拿到这些信息,就能给你更靠谱的回答啦。

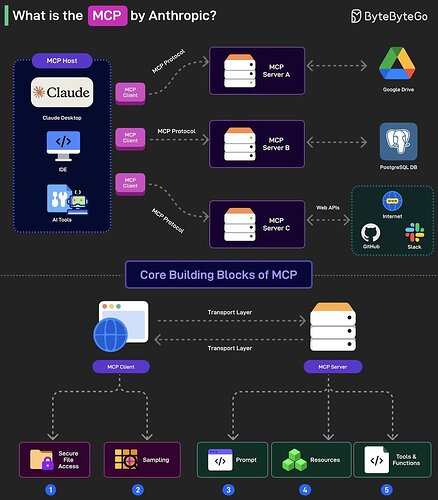

MCP 有三个关键角色:

- MCP 主机(Host): 就是跑 AI 应用的地方,比如 Claude 在哪儿运行,那儿就是 MCP 主机。

- MCP 客户端(Client): 藏在 AI 模型里面,专门负责用 MCP 协议跟 MCP 服务器“聊天”。

- 举个栗子: Claude 想从 PostgreSQL 数据库里拿销售数据,客户端就把请求整理好,发给 MCP 服务器。

- MCP 服务器 (Server): 就像个中间人,连接 AI 模型和外面的世界。 它收到客户端的请求,理解 AI 想干啥,然后去外面找数据或者执行操作,最后把结果告诉 AI。

- 每种外部资源(PostgreSQL、Google Drive、各种 API)都有自己的 MCP 服务器。

- 再举个栗子: Claude 要从 PostgreSQL 拿数据,PostgreSQL 的 MCP 服务器就收到请求,跟数据库“沟通”,拿到数据,再发回给 Claude。

MCP 的五个基本要素 (技术细节,可以跳过):

- 客户端侧 (Client-side):

- Roots (安全文件访问): 让你安全地访问文件和文档。

- Sampling (抽样/任务辅助): 让 AI 帮你干点活,比如生成数据库查询。

- 服务器侧 (Server-side):

3. Prompts (提示/指令): 告诉 AI 怎么回答你。

4. Resources (资源/数据对象): AI 可以用到的数据,比如数据库里的表格或者 Google Drive 里的文件。

5. Tools (工具/功能): AI 可以执行的操作,比如运行数据库查询或者调用 API。

大家都说 MCP,到底牛在哪儿?

- 集成更简单:

- 以前,你想让 AI Agent 用你的文件、日历啥的,得为每个连接写一堆代码。

- 现在,MCP 定义了一套标准“协议”,就像个“万能插头”。

- 开发者不用为每个新工具搞定制集成,只要部署对应的 MCP 服务器就行。

- AI 能力更强: 有了 MCP,AI 模型能轻松访问各种外部信息和工具,能力大大提升。 比如:

- 智能助手: 帮你安排日程、处理邮件。

- 数据分析: 直接分析数据库、云盘里的数据,给你更深的洞察。

- 自动化工作流: 自动完成复杂的工作流程。

- AI 应用更容易普及: MCP 让开发 AI 应用变得更简单、更便宜。

- 开源: 谁都能用、贡献代码,或者在它的基础上开发新东西。

这么看,Agent 其实就是:

Claude + MCP Client + MCP Servers = Agent

- Claude: 负责思考和推理。

- MCP 客户端: 让 Claude 能跟外部世界“对话”。

- MCP 服务器: 连接各种工具、数据源的中介。

没有 MCP,Claude 就只是个厉害的语言模型,只能用它自己脑子里的知识。

MCP 是解锁 Claude 潜力的关键,让它变成真正的 Agent —— 不只能理解和生成文字,还能跟世界互动,解决问题,实现目标。

MCP 都能用在哪儿?

- 个人 AI 助手 — 管理日历、总结邮件、找文件

- BI (商业智能) — 从公司数据里挖出有用的信息

- 软件开发 — 帮你找代码片段和文档

- 客户支持 — 让 AI 访问历史对话,更好地回答问题

谁来做 MCP 服务器 (Server) 呢?

MCP 服务器一般由下面这些家伙来做:

- 工具和服务提供商: 像 Google、Slack、PostgreSQL 这些公司,他们可以为自己的产品搞 MCP 服务器,让它们能跟 AI 模型“联动”。 Cloudflare 就做了自己的 MCP Server。

- 第三方开发者: 独立开发者和公司可以为常用工具和服务开发 MCP 服务器,特别是那些官方还没做的。

- 开源社区贡献者: 因为 MCP 是开放的,所以开源社区的人也能为各种工具和数据源开发 MCP 服务器。 已经有网友做了 AWS 的 MCP。